AKT-note

- 论文标题:Context-Aware Attentive Knowledge Tracing

- 作者与发表日期: Ghosh, Aritra and Heffernan, Neil and Lan, Andrew S.

- 期刊或会议名称:KDD ‘20: The 26th ACM SIGKDD Conference on Knowledge Discovery and Data Mining Virtual Event CA USA July 6 - 10, 2020

- 链接:https://arxiv.org/abs/2007.12324

- DOI: 10.1145/3394486.3403282

- 摘要: 知识追踪 (KT) 是指根据学习者过去在教育应用程序中的表现来预测未来学习者的表现的问题。使用基于灵活深度神经网络的模型的 KT 的最新发展在这项任务中表现出色。然而,这些模型的可解释性通常有限,因此不足以进行个性化学习,这需要使用可解释的反馈和可操作的建议来帮助学习者获得更好的学习成果。在本文中,我们提出了注意力知识追踪 (AKT),它将灵活的基于注意力的神经网络模型与一系列受认知和心理测量模型启发的新型、可解释的模型组件相结合。AKT 使用一种新颖的单调注意力机制,将学习者未来对评估问题的回答与他们过去的回答联系起来;除了问题之间的相似性外,注意力权重是使用指数衰减和上下文感知相对距离测量来计算的。此外,我们使用 Rasch 模型来正则化概念和问题嵌入;这些嵌入能够捕获关于同一概念的问题之间的个体差异,而无需使用过多的参数。我们在几个真实世界的基准数据集上进行了实验,结果表明 AKT 在预测未来学习者的反应方面优于现有的 KT 方法(在某些情况下,AUC 高达 6%)。我们还进行了几个案例研究,表明 AKT 表现出出色的可解释性,因此在现实世界的教育环境中具有自动反馈和个性化的潜力。

Introduction

ht代表t时刻的知识水平,rt代表t时刻对评估问题的回答评分(通常是二进制值,1代表回答正确,0则反)。因此前一个函数称为回答模型(response model),后一个称为知识进化模型(knowledge evolution model)。

其他模型和方法:

- DKT:每个学习者对专家定义的概念的 Nowledge 级别。KT 的最新发展集中在:使用更复杂和灵活的模型来充分利用大规模学习者响应数据集中所包含的信息。深度知识追踪 (DKT) 方法是第一种通过使用长短期记忆 (LSTM) 网络作为知识进化模型 g(·) 来探索(可能是深度)神经网络用于 KT 的方法。由于 LSTM 单元是非线性的复杂函数,因此它们比仿射变换更灵活,并且更能够捕获真实数据中的细微差别

- DKVMN:动态键值记忆网络 (DKVMN) 方法通过使用外部记忆矩阵 (Ht) 来表征学习者知识 。该矩阵分为两部分:一个静态的“关键”矩阵,其中包含每个概念的固定表示,以及一个动态的“价值”矩阵,其中包含每个学习者对每个概念的不断发展的知识水平。DKVMN 还在这个外部矩阵上为响应和知识进化模型使用单独的 “read” 和 “write” 过程;这些过程使其比 DKT 更灵活。DKT 和 KVMN 报告了预测未来学习者表现的最新性能 ,并已成为新 KT 方法的基准。

- SAKT:自我关注知识追踪(SAKT)方法是在KT环境中使用注意力机制的第一种方法。注意力机制比递归和基于记忆的神经网络更灵活,并且在自然语言处理任务中表现出卓越的性能。SAKT 的基本设置与 Transformer 模型 有许多相似之处,Transformer 模型是许多序列到序列预测任务的有效模型。然而,我们观察到 SAKT 在我们的实验中并没有优于 DKT 和 DKVMN 。可能的原因包括:

i) 与单词之间常常具有强烈长距离依赖性的语言任务不同,未来学习者表现对过去的依赖性可能仅限于更短的窗口;

ii) 学习者响应数据集的大小比自然语言数据集小几个数量级,并且不太可能从高度灵活和大规模的注意力模型中受益。

更重要的是,没有现有的 KT 方法真正擅长未来性能预测和可解释性。早期的 KT 方法表现出出色的可解释性,但在预测未来学习者的表现方面没有提供最先进的性能。最近基于深度学习的 KT 方法在这方面表现出色,但提供的可解释性有限。因此,这些知识转移方法并不能完全满足个性化学习的需求,这不仅需要准确的表现预测,还需要提供自动化、可解释的反馈和可操作的建议的能力,以帮助学习者获得更好的学习成果。

Contributions

为了预测学习者对当前问题的回答,我们提出了注意力知识追踪 (AKT) 方法,该方法使用一系列注意力网络在这个问题和学习者过去回答的每个问题之间建立联系。我们总结了以下主要创新:

- 与使用原始问题和响应嵌入的现有注意力方法相反,我们将原始嵌入放入上下文中,并通过考虑学习者的整个实践历史,使用过去问题和响应的上下文感知表示。

- 受认知科学关于遗忘机制的发现的启发,我们提出了一种新的单调注意力机制,它使用指数衰减曲线来降低遥远过去问题的重要性。我们还开发了一个上下文感知度量来描述学习者过去回答的问题之间的时间间隔。

- 利用 Rasch 模型,一种简单且可解释的 IRT 模型,我们使用一系列基于 Rasch 模型的嵌入来捕捉问题之间的个体差异,而无需引入过多的模型参数。

Problem Setup

每个学习者的表现记录都包含每个离散时间步长的一系列问题和回答。对于时间步 t 的学习者 i,我们表示他们回答的问题、这个问题涵盖的概念以及他们以元组形式给出的分级响应的组合(qit , cti , rti ),其中 qit ∈ N+ 是问题索引,cti ∈ N+ 是概念索引,rti ∈ {0, 1} 是回答。在此表示法下,(qit , cti , 1) 表示学习者 i 在时间 t 正确回答了概念 cti 上的问题 qit。此设置与之前的一些深度知识跟踪工作不同,这些工作经常忽略问题索引并将学习者的表现总结为 (cti , rti )。做出这个选择是为了避免过度参数化;在以下讨论中,我们省略了上标 i,因为我们讨论了如何预测单个学习者的未来表现。鉴于他们过去到时间 t − 1 的历史为 {(q1, c1, r1), . . , (qt −1, ct −1, rt −1)},我们的目标是预测他们在当前时间步 t 对概念 ct 上的问题 qt 的回答 rt。

问题和回答的嵌入表达

我们使用实值嵌入向量xt ∈ RD和yt ∈ RD来分别表示每个问题和每个问题-响应对(qt、rt)。

- xt 描述有关问题的信息 ;

- 而 yt 描述学习者通过回答问题获得的知识,分别使用两个单独的嵌入来表示正确和错误的回答。

D 表示这些嵌入的维度。因此,让 Q 表示问题的数量,总共有 Q 个问题嵌入向量和 2Q 个问题-响应嵌入向量。在大多数现实世界的教育环境中,题库比概念集大得多,并且许多问题被分配给极少数学习者。因此,大多数现有的 KT 方法都使用概念来索引问题以避免过度参数化 ; 涵盖同一概念的所有问题都被视为单个问题。在这种情况下,qt = ct 即Q = C。

THE AKT METHOD

AKT 方法由四个部分组成:

1)两个自注意编码器,一个用于问题,一个用于知识获取,

2)一个基于注意力的知识检索器

3)一个前馈响应预测模型

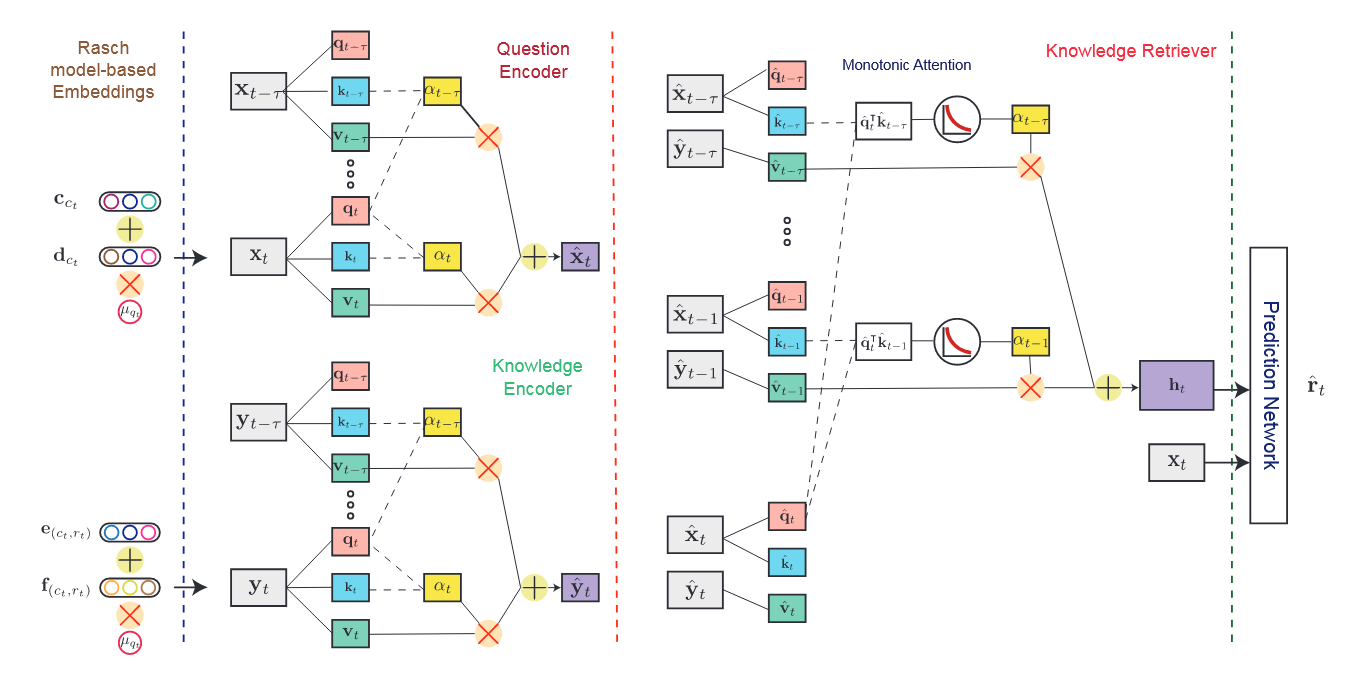

下图直观地显示了 AKT 方法及其连接组件。

图 1:AKT 方法概述。我们使用基于 Rasch 模型的嵌入作为问题和响应的原始嵌入。问题和知识编码器计算问题和响应对的上下文感知表示形式。知识检索器使用这些表示形式作为输入,并计算学习者的知识状态。为简单起见,我们不在编码器中展示单调注意力机制。我们也不显示子图层。

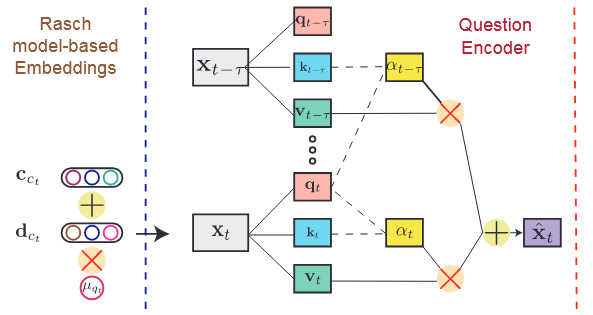

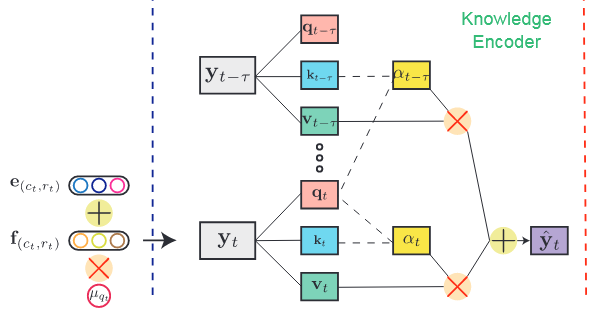

我们使用两个自我关注编码器来学习问题和回答的上下文感知表示。我们将第一个编码器称为问题编码器,它会根据学习者之前练习过的问题序列,为每个问题生成经过改良的、情境化的表示。同样,我们将第二个编码器称为知识编码器,它生成学习者在回答过去问题时获得的知识的改良后的、情境化表示。或者,我们可以使用类似于之前工作的问题和响应的原始嵌入。我们发现,上下文感知表示在大多数数据集中表现更好。我们将知识进化模型称为知识检索器,它使用注意力机制检索过去获得的与当前问题相关的知识。最后,响应预测模型使用检索到的知识预测学习者对当前问题的响应。

AKT 方法的动机是植根于认知科学和心理测量学的三种直觉。

上下文感知表达和知识检索器

我们在模型中使用了两个编码器。问题编码器将原始问题嵌入 {x1, . . . , xt } 作为输入,并使用单调注意力机制输出一系列上下文感知问题嵌入 {xˆ1, . . ., ˆxt }。每个问题的上下文感知嵌入取决于自身和过去的问题,即 ˆxt = fenc1 (x1, . . . , xt )。

同样,知识编码器将原始问题-响应嵌入 {y1, . . . , yt−1} 作为输入,并使用相同的单调注意力机制输出获得的实际知识序列 {yˆ1, . . . , yˆt−1}。所获知识的语境感知嵌入取决于学习者对当前问题和过去问题的回答,即 yˆt−1 = fenc2 (y1, . . . , yt −1)。

选择使用上下文感知嵌入而不是原始嵌入反映了我们的第一种直觉:学习者在回答问题时理解和学习的方式取决于学习者。这些修改后的表示反映了每个学习者对问题的实际理解以及他们根据个人回答历史实际获得的知识。这种模型选择的动机是出于直觉,即对于过去反应序列不同的两个学习者,他们理解同一问题的方式和他们从练习中获得的知识可能会有所不同。

知识检索器将上下文感知问题和问题-响应对嵌入 ˆx1:t 和 yˆ1:t −1 作为输入,并输出针对当前问题的检索到的知识状态 ht。我们注意到,在 AKT 中,学习者的当前知识状态也是上下文感知的,因为它取决于他们正在回答的当前问题 。知识检索器只能使用有关过去问题的信息、学习者对这些问题的回答以及当前问题的表示形式,而不能使用学习者对当前问题的回答,即 ht = fkr(ˆx1, . . . ,xˆt , yˆ1, . . . ,yˆt−1)。响应预测模型使用检索到的知识来预测当前响应。

单调注意力机制

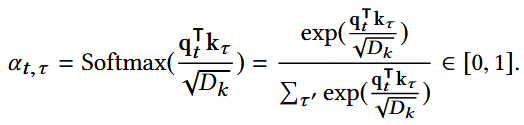

我们对编码器和知识检索器使用缩放点积注意力机制修改后的单调版本。我们首先简要总结一下最初的缩放点积注意力机制:在此框架下,每个编码器和知识检索器都有一个键、查询和值嵌入层,该层将输入分别映射到维度 Dq = Dk 、 Dk 和 Dv 的输出查询、键和值。设 qt ∈ RDk ×1 表示与学习者在时间 t 回答的问题相对应的查询,缩放的点积注意力值 αt,τ 使用 softmax 函数计算为

两个编码器都采用自注意力机制,即 qt 、 kt 和 vt(查询、键、值) 是使用相同的输入计算的 ; 问题编码器使用 {x1, . . . , xt },而知识编码器使用 {y1, . . . , yt−1}。

另一方面,知识检索器不使用自我注意。在时间步 t 处,它使用:

- ˆxt(当前问题的修改嵌入)、{ ˆx1, . . . , ˆxt−1}(过去问题的上下文感知嵌入)

- {yˆ1, . . . , yˆt−1}(过去问题-响应对的上下文感知嵌入)作为输入

来分别生成查询、键和值。我们注意到,SAKT 使用问题嵌入向量来映射查询,而使用响应嵌入向量来映射键和值。在我们的实验中,我们发现使用问题嵌入来映射查询和键要有效得多。

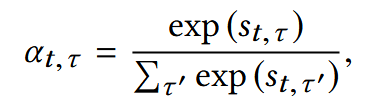

然而,这种基本的缩放点积注意力机制对 KT 来说可能还不够。原因是学习是暂时的,记忆会衰减 ; 当我们预测学习者对当前问题的回答时,学习者在遥远过去的表现不如最近的表现提供信息。因此,我们开发了一种新的单调注意力机制来反映我们的第二直觉:当学习者面临一个新问题时,过去在不相关概念上的经验 和 太久以前的经验不太可能高度相关。具体来说,我们在注意力分数中添加一个乘法指数衰减项,如下所示:

以及:

其中 θ > 0 是可学习的衰减率参数,d(t,τ )是时间步长 t 和 τ 之间的时间距离测量。换句话说,当前问题对过去问题的关注权重不仅取决于对应 query 和 key 之间的相似度,还取决于它们之间的相对时间步长数。总之,我们的单调注意力机制采用随时间呈指数衰减曲线的基本形式,当过去的问题与当前问题高度相似时,时间步长可能会出现峰值。注意,我们将指数衰减应用于注意力权重而不是潜在知识,这是现有学习者模型中的常见方法。

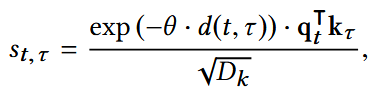

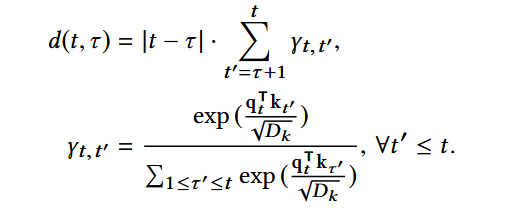

上下文感知距离度量

指数衰减函数决定了注意力权重随着当前时间索引与先前时间索引之间距离的增加而衰减的速率。定义两个时间索引之间距离的一种直接方法是它们的绝对值差。但是,此距离不是上下文感知的,并且会忽略每个学习者的练习历史记录。

例如,考虑学习者练习的以下两个概念序列:PN1、VD2、VD3、···、VD9、PN10

其中,PN和VD分别代表有素数概念和韦恩图概念的练习题。

即,符号“VD2”表示学习者在时间步 2 时刻练习了维恩图的概念。在此示例中,学习者回答了关于 t = 10 处的质数(即当前时间索引)的问题,但过去关于质数的最新做法是不同的时间索引。由于维恩图和素数的概念并不密切相关,因此在预测学习者对当前练习题的回答时,学习者以前对素数的练习比最近对维恩图的练习更与我们相关。

在这种情况下,由于绝对值差值简单明了,指数衰减曲线将显著降低在 t = 1 时分配给素数练习的注意力权重。因此,我们提出了以下时间步长 d(t, τ ) 之间的上下文感知距离测量,τ ≤ t,用于指数衰减机制(在编码器中):

对于知识检索器,我们将 τ ′ ≤ t 替换为 τ < t,将 t ′ ≤ t 替换为 t ′ < t。换句话说,这种上下文感知距离测量使用另一个 softmax 函数,根据过去实践的概念与当前概念的关系来调整连续时间索引之间的距离(?)。在实践中,在模型训练期间的每次迭代中,我们使用当前的 AKT 模型参数来计算修改后的距离度量并对其进行修复 ; 我们不会通过 Distance 度量传递梯度。

多头注意力和子图层

本文方法还纳入了多头注意力,在多个时间尺度上有效地关注过去的位置 。因此使用了 H 个独立的注意力头,其中每个头都有自己的衰减率 θ ,将最终输出连接成一个 (Dv ·H ) × 1 向量并将其传递给下一层。这种模型设计使 AKT 能够在多个时间尺度上总结过去的学习者表现,这与多尺度上下文、DASH 和 DAS3H 模型中的多个时间窗口有一些相似之处 。

我们还使用了几个子层,包括一个用于层归一化 ,一个用于 dropout ,一个全连接前馈层,以及每个编码器和知识检索器中的残差连接层 。

响应预测

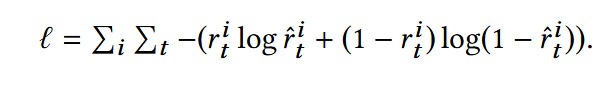

AKT 方法的最后一个组件:预测学习者对当前问题的回答。预测模型的输入是一个向量,它连接检索到的知识(知识检索器输出 ht )和当前问题嵌入 xt 。此输入通过另一个全连接网络,最后通过 sigmoid 函数生成学习者正确回答当前问题的预测概率 rˆt ∈ [0, 1]。整个 AKT 方法中的所有可学习参数都以端到端方式进行训练,方法是最大限度地减少所有学习器响应的二进制交叉熵损失,即

基于Rasch模型的嵌入

正如我们上面所讨论的,现有的 KT 方法使用概念来索引问题,即设置 qt = ct 。由于数据稀疏性,此设置是必要的。让 Q 表示问题总数,L 表示学习者的数量。在大多数实际学习者响应数据集中,学习者响应的数量与 CL 相当,但比 QL 少得多,因为许多问题被分配给少数学习者。因此,使用概念为问题编制索引可以有效避免过度参数化和过度拟合。然而,这种基本设置忽略了涵盖同一概念的问题之间的个体差异,从而限制了 KT 方法的灵活性及其个性化的潜力 。

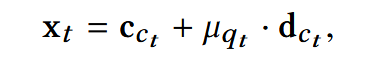

我们使用心理测量学中一个经典而强大的模型,即 Rasch 模型(也称为 1PL IRT 模型)来构建原始问题和知识嵌入。Rasch 模型使用两个标量来描述学习者正确回答问题的概率:问题的难度和学习者的能力。尽管它很简单,但事实证明,当知识是静态的时候,它在正式评估中可以实现与更复杂的学习者表现预测模型相当的性能。具体来说,我们从位于时间步t的概念ct来说:

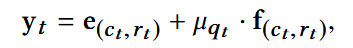

其中 cct ∈ RD 是此问题涵盖的概念的嵌入,dct ∈ RD 是总结涵盖此概念的问题们的变化的向量,μqt ∈ R 是一个标量难度参数,控制此问题偏离其涵盖的概念的程度。概念 ct 中的问题-响应对 (qt , rt ) 使用每对的标量难度参数以类似方式扩展:

其中 e(ct,rt ) ∈ RD 是概念-响应嵌入, 和f(ct,rt ) ∈ RD是变化向量。这个模型的选择反映了我们的第三个直觉:标记为涵盖相同概念的问题密切相关,但具有不应忽视的重要个体差异。这种模型选择部分受到了另一项融合 KT 和 IRT 模型的工作的启发 [8]

[8] MM Khajah, Y Huang, JP González-Brenes, MC Mozer, and P Brusilovsky. 2014. Integrating knowledge tracing and item response theory: A tale of two frameworks. In Proc. International Workshop on Personalization Approaches in Learning Environments, Vol. 1181. 7–15.

这些基于 Rasch 模型的嵌入在建模个体问题差异和避免过度参数化之间取得了适当的平衡。我们注意到, question 和 question-response embeddings 共享一组参数 (cct ); 此设置与现有的基于神经网络的 KT 方法不同,在这两种方法中,两者彼此独立。这些紧凑的嵌入表示不仅显着减少了 AKT 中的参数数量,还减少了其他一些 KT 方法中的参数数量,从而提高了未来学习者性能预测的性能 ; 有关详细信息,请参见表 5。

Experimental Results

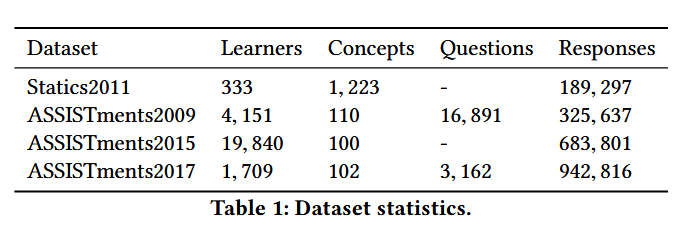

在所有这些数据集上,我们遵循文献中的一系列标准预处理步骤。对于 ASSISTments2009 数据集,我们删除了所有未与命名概念关联的交互。对于 ASSISTments2015 数据集,我们删除了 “isCorrect” 字段不是 0 或 1 的所有交互。我们在表 1 中列出了学习者、概念、问题和 questionresponse 对的数量。在这些数据集中,只有 ASSISTments2009 和 ASSISTments2017 数据集包含问题 ID ; 因此,基于 Rasch 模型的嵌入仅适用于这两个数据集。

基线方法和评估指标

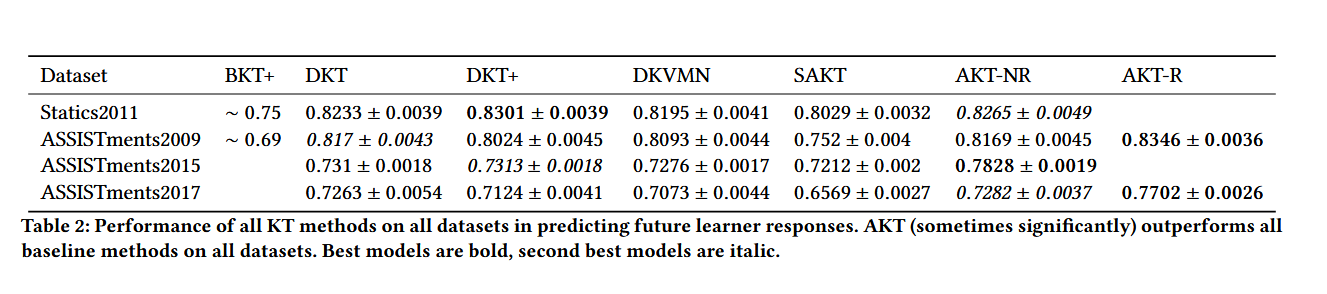

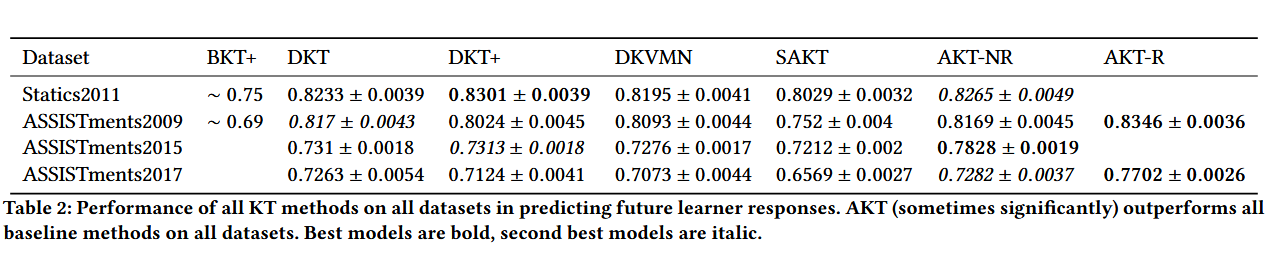

我们将AKT与几种基线KT方法进行了比较,包括BKT+、DKT、DKT+(这是DKT的改进版本,对预测一致性进行了正则化)、DKVMN 和最近提出的SAKT方法,该方法使用一种注意力机制,可以看作是AKT的一个特殊情况,没有问题和回答的上下文感知表示以及单调的注意力机制。我们使用受试者工作特征曲线下面积 (AUC) 作为指标来评估所有 KT 方法在预测二进制值未来学习者对问题的反应方面的性能。

训练和测试

出于评估目的,我们对所有模型和所有数据集执行标准的 k 折交叉验证(k = 5)。因此,对于每个折叠,20% 的学习者用作测试集,20% 的学习者用作验证集,60% 的学习者用作训练集。对于每个折叠,我们使用验证集来执行早期停止并调整每种 KT 方法的参数。出于计算效率的原因,我们按照截断了长度超过 200 的学习器响应序列。如果学习者的响应超过 200 个,我们会将其整个序列分解为多个较短的序列。我们使用 Adam 优化器来训练所有模型,批处理大小为 24 个学习者,以确保整个批处理可以放入我们机器的内存(配备一个 NVIDIA Titan X GPU)。我们在 PyTorch 中实现所有版本的 AKT ; 我们还重新实现了 DKT、DKT+ 和 SAKT,因为包含问题 ID 需要新的数据集分区并导致新的实验结果。

表 2 列出了所有数据集中所有 KT 方法在预测未来学习者反应方面的性能;我们报告了 5 个测试折叠的平均值和标准差。AKT-R 和 AKT-NR 分别表示具有和没有基于 Rasch 模型的嵌入的 AKT 模型的变体。我们看到 AKT(有时显着)在 ASSISTments 数据集上优于其他 KT 方法,而 DKT+ 在最小的 Statics2011 数据集上略优于 AKT。通常,AKT 在较大的数据集上表现更好;这一结果表明,注意力机制比递归神经网络更灵活,因此更能够捕获大规模真实世界学习者反应数据集中包含的丰富信息。在 ASSISTments2015 和 ASSISTments2017 数据集上,AKT-NR 将 AUC 分别比最接近的基线提高了 6% 和 1%。它的性能与 Statics2011 和 ASSISTments2009 数据集上性能最佳的基线相当。更重要的是,在带有问题 ID 的 ASSISTments2009 和 2017 数据集上,AKT-R 的性能明显优于其他 KT 方法,分别比最接近的基线高出 2% 和 6%。我们注意到,在我们的实现中,DKT 优于更高级的 DKVMN 方法。

在带有问题 ID 的 ASSISTments2009 和 2017 数据集上,AKT-R 的性能明显优于其他知识追踪(KT)方法,主要原因与基于 Rasch 模型的嵌入和问题 ID 的使用相结合有关:

- Rasch 模型的嵌入:Rasch 模型是一种测量模型,广泛应用于教育领域,主要用于测量问题的难度和学生的能力。通过将 Rasch 模型的嵌入加入到 AKT 中,模型可以更好地估计不同问题的难度以及学生的能力差异,这种精细的刻画提升了模型对学习者反应的预测能力。问题 ID 提供了特定问题的详细信息,而 Rasch 模型的嵌入能根据这些 ID 更精确地调整预测,从而提升了性能。

- 问题 ID 的额外信息:带有问题 ID 的数据集可以提供比仅仅是知识点(如“数学中的代数”)更具体的细节。问题 ID 指定了特定的题目,这让模型能够区分出同一知识点下不同题目的差异性。而基于问题 ID 的 Rasch 嵌入可以帮助模型更好地理解每个具体问题的特征和学习者的应对情况,从而增强模型的细粒度预测能力。

- 灵活的注意力机制:AKT 使用了注意力机制,能够在不同学习步骤间选择性地关注重要的信息。在带有问题 ID 的数据集上,注意力机制可以更灵活地捕捉每个问题的特征,特别是结合 Rasch 嵌入后,模型能够专注于难度差异显著的问题以及与学习者能力匹配的题目,从而提供更好的预测。

消融研究

为了证明 AKT 方法中三个创新点的合理性:

- 问题和回答的上下文感知表示

- 单调注意力机制

- 基于 Rasch 模型的嵌入( 将难度和能力的概念引入到特征空间中 )

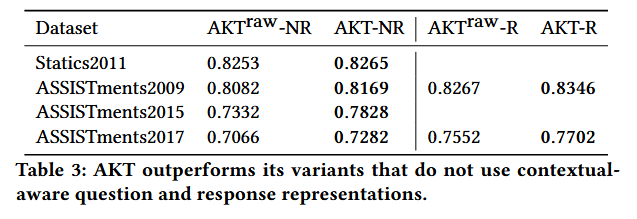

第一个实验将 AKT-NR 和 AKT-R 与两种变体 AKTraw-NR 和 AKTraw-R 使用上下文感知问题和响应表示(带有问题和知识编码器)进行了比较;在这些变体中,我们使用原始的问题和响应嵌入作为它们的表示形式,而不是上下文感知的表示形式(即,不通过编码器传递它们)。

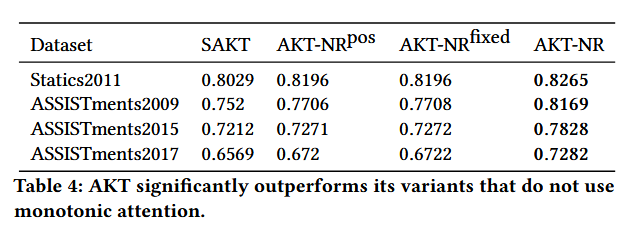

表 3:AKT 优于不使用上下文感知问题和响应表示的变体。

表 3 显示了上下文感知表示(即问题和知识编码器)的第一次消融实验的结果(由于空间限制,只有测试折叠之间的平均值,而不是标准差)。在所有数据集上,AKT-R 和 AKTNR 的性能都优于它们的对应数据集 AKTraw-NR 和 AKTraw-R,它们只使用具有指数衰减的单一自我注意机制(即知识检索器)。这些结果表明,我们对问题和回答的上下文感知表示可以有效地总结每个学习者的实践历史。

第二个实验将 AKT-NR 与没有单调注意力机制的几种变体进行了比较。这些变体包括 AKT-NRpos,它使用(可学习的)位置编码来捕获学习者响应数据中的时间依赖性,以及 AKT-NRfixed,它使用(固定)位置编码,使用不同频率的正弦和余弦函数 [29]。

表 4:AKT 明显优于其不使用单调注意力的变体。

表 4 显示了单调注意力机制的第二次消融实验的结果。我们看到,在所有数据集上,AKT-NR 明显优于其他使用位置嵌入的注意力机制,包括 SAKT,大约是 1% 到 6%。我们假设造成这一结果的原因是:与单词之间强烈的长距离依赖性更常见的语言任务不同,未来学习者的表现对过去的依赖性仅限于更短的时间窗口。因此,在注意力权重中使用具有不同指数衰减率的多头注意力可以有效地捕捉不同时间尺度上对过去的短期依赖性。

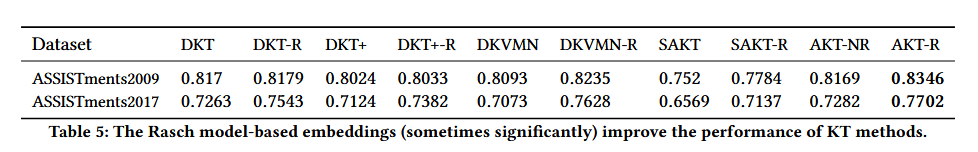

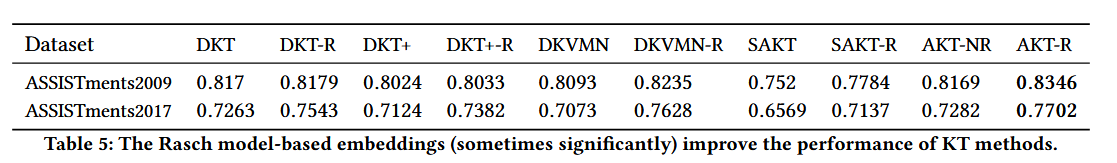

第三个实验在有问题 ID 可用的 ASSISTments2009 和 2017 数据集上将 AKT-R 与 AKT-NR、DKT、DKT-R、DKT+、DKT+-R、DKVMN、DKVMN-R、SAKT 和 SAKT-R 进行了比较;DKT-R、DKT+-R、DKVMN-R 和 SAKT-R 分别是指使用基于 Rasch 模型的嵌入作为输入增强的 DKT、DKT+、DKVMN 和 SAKT 方法。

表 5:基于 Rasch 模型的嵌入(有时显着)提高了 KT 方法的性能。

表 5 显示了在两个 ASSISTments 数据集上基于 Rasch 模型的嵌入的第三次消融实验的结果,其中问题 ID 可用。所有添加了基于 Rasch 模型的嵌入的基线 KT 方法均优于其常规版本,尤其是在 ASSISTments2017 数据集上。这些结果证实了我们的直觉,即将涵盖同一概念的所有问题视为单个问题是有问题的 ; 只要可以避免过度参数化,这些问题之间的个体差异就不应该被忽视。

【备注】 在实验设置中,对于标记了多个概念的问题,单个学习者回答将重复多次,每个概念重复一次。其他作品对这些问题使用了不同的实验设置 ; 在 [31] 中,作者删除了这些问题,结果,DKT 的性能下降到 0.71。在 [33] 中,作者为同时出现的单个概念的每个组合构建了新概念,结果,DKT 的性能下降到 0.73。因此,我们还在 ASSISTments2009 数据集上使用了另一种实验设置。对于标记了多个概念的问题,我们会对相应的概念嵌入进行平均,并将其用作输入嵌入和响应预测。表 6 列出了此设置下所有 KT 方法在 ASSISTments2009 数据集上的性能。使用平均嵌入时,DKT 的性能下降到 0.76,比 [31, 33] 下的设置要好。与所有 KT 方法的标准实验设置相比,我们观察到类似的性能下降,而 AKT-R 仍然轻松优于所有基线。(这部分有点没懂)

可视化参数

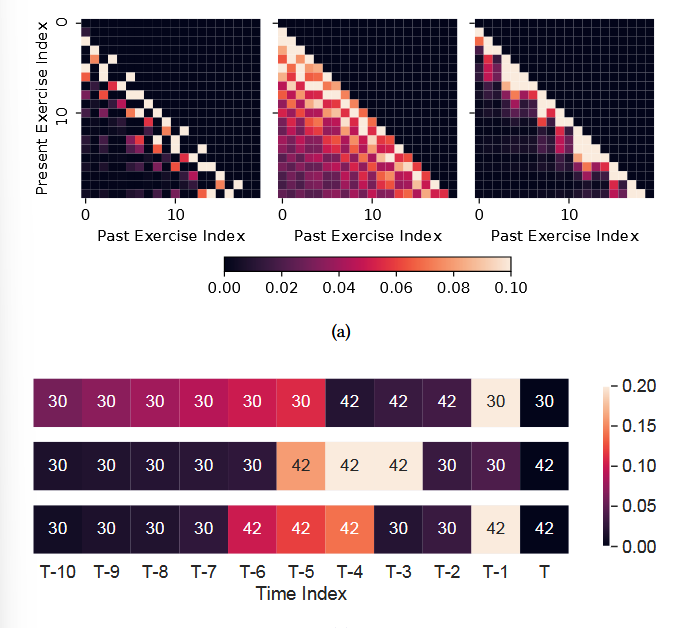

图(a)是AKT 解码器中三个注意力头的 注意力权重的可视化

图(b)是学习者三个连续练习题的注意力权重(以T为最临近的)

图可反映出来:概念相似度和新近度是控制注意力权重的关键因素。

图的详细解释:图(b)可视化了单个学习者在三个连续时间步长中的知识检索器中的标准化注意力权重。在最上面一行中,学习者在从 T − 10 到 T − 5 练习概念 T 后,在时间 T 回答概念 30 的问题,然后休息后继续练习概念 42,然后在时间 T − 1 回到概念 30。我们看到,AKT 通过更多地关注关于这个概念的先前实践(包括不久的过去和更远的过去)而不是不久前的另一个概念的实践来预测他们对当前问题的回答。在中间一行,学习者再次切换到 Concept 42 练习。同样,AKT 学会了关注同一概念的过去实践,而不是在时间 T − 2 和 T − 1 的不同概念上关注不久的过去。在最下面一行中,学习者连续第二次练习概念 42,AKT 显示出与最上面行类似的焦点模式,概念 30 和 42 的角色互换了。这些观察结果表明,AKT 的单调注意力机制有可能通过将学习者当前的反应与他们过去的反应联系起来来向教师提供反馈 ; 这些信息可能使教师能够选择他们已经练习过的某些问题,以便他们在继续之前重新练习并消除误解。我们还注意到,AKT 使用数据驱动的方法,学习这些与现有 KT 方法中的手工制作特征相匹配的注意力模式(例如,对这个概念的总尝试次数和正确尝试次数) (有这么厉害吗)

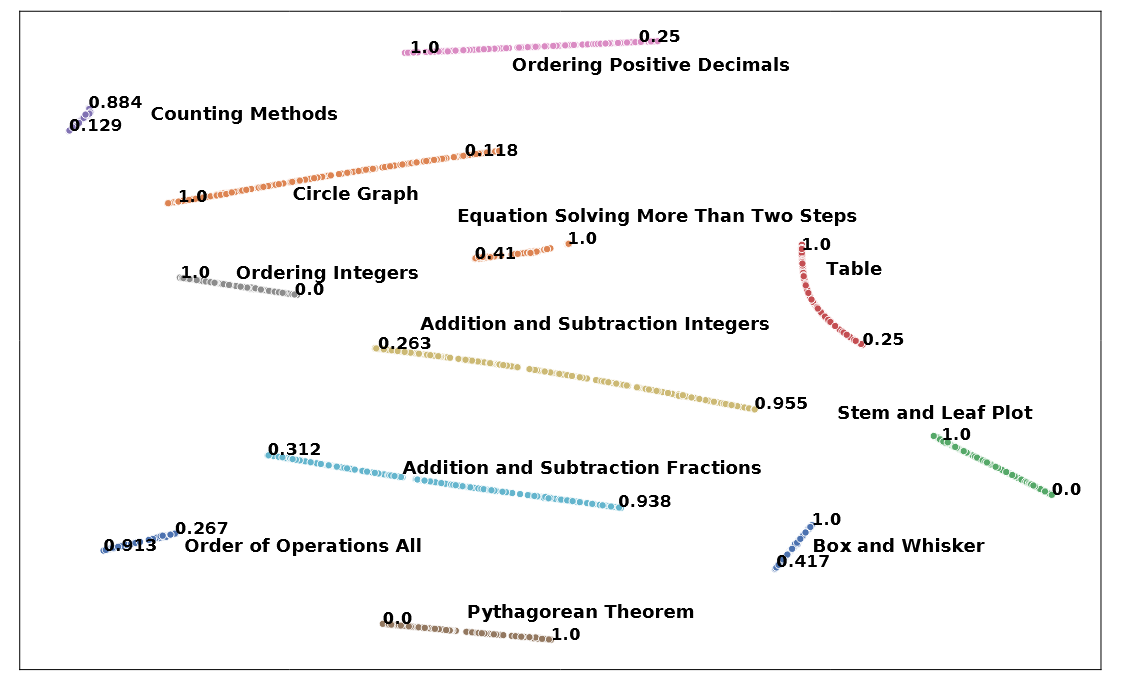

图 3:学习到的问题嵌入的可视化,以及学习者对所选概念的正确回答比例。

Rasch 基于模型的嵌入

图 3 使用 ASSISTments2009 数据集使用 t-SNE [28] 可视化了几个概念的基于 Rasch 模型的学习问题嵌入,以及它们对选定问题(学习者正确回答的部分)的经验困难。我们还基于它们的实证困难突出了每个概念的最难的和最简单的问题。我们看到,关于同一概念的问题形成一条曲线,并按其难度级别排序:对于大多数概念,线段一端的问题是简单的,而另一端的问题是困难的。这个结果证实了我们的直觉,即来自同一概念的问题并不相同,而是彼此密切相关 ; Rasch 模型可以使用其 difficulty 参数很好地捕捉到这种关系。

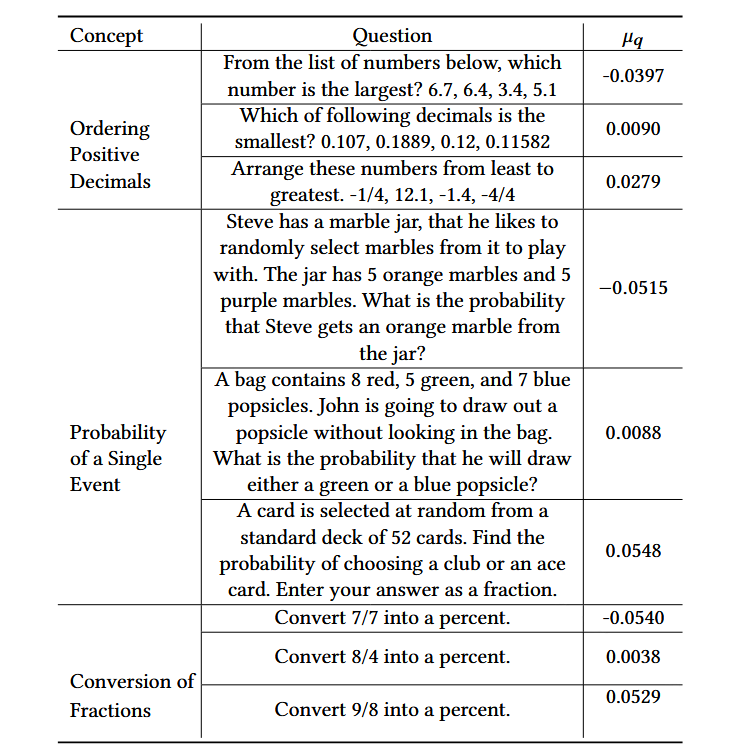

表 7:关于三个概念的选定问题的问题文本和学习难度参数 (μq)。习得的难度级别符合我们对这些问题难度的直觉。

表 7 列出了三个不同概念的示例问题,即“对正小数进行排序”、“单个事件的概率”和“分数到百分比的转换”,以及它们学习的难度参数。我们为每个概念展示了三个问题:一个简单的问题、一个普通的问题和一个困难的问题。以“单个事件的概率”概念为例,学习的难度参数值 (μq ) 为简单难度为 −0.0515,平均难度为 0.0088,困难难度为 0.0548。这些学习的难度级别与我们对这些问题的难度级别的理解相符。

这些结果表明,AKT 有可能应用于现实世界的教育环境。使用估计的难度参数,计算机化学习平台可以:

- 根据每个学习者过去的回答自动选择具有适当难度级别的问题

- 通过向教师提供从真实数据中学到的问题难度级别的反馈来支持教师调整课程计划。

因此,AKT 不仅通过提供最先进的预测性能,而且还表现出可解释性和个性化学习的潜力,从而改进了现有的 KT 方法。

Conclusion and Future Work

在本文中,我们提出了注意力知识追踪,这是一种完全依赖于注意力网络的知识追踪新方法。我们的方法通过(1)构建问题和回答的上下文感知表示,**(2)使用单调注意力机制在正确的时间尺度上总结过去的学习者表现,以及(3)使用 Rasch 模型来捕捉涵盖同一概念的问题之间的个体差异**,从而改进了现有的知识追踪方法。在一系列基准真实世界学习者反应数据集上的实验结果表明,我们的方法优于最先进的 KT 方法,并表现出出色的可解释性。未来工作的途径包括 :

合并问题文本以进一步增强问题和概念嵌入的可解释性

测试我们的方法是否可以提高发生记忆衰减的语言学习数据集的预测性能